“灵感”模型使用大量图像数据预训练,使得模型对图像具有很好的表达能力和泛化性,因此它能被使用到各种下游的视觉任务中提升下游模型的效果。作为视觉基础模型,可以通过线性探测或下游任务的效果表征视觉基础模型的效果。线性探测(LinearProbing)是一种用于评估预训练模型性能的方法,通过替换模型的最后一层为线性层并保持其余部分不变。在此过程中,仅训练这个线性层,以测试模型的表征学习能力。

我们对比了CLIP和OpenCLIP在26个分类测试集中线性探测的结果,同等模型下我们平均准确率比OpenCLIP高2.3%,比CLIP高1.1%。

| DATASET | Glint-MVT | CLIP | OPNCLIP |

|---|---|---|---|

| CIFAR100 | 92.0 | 87.5 | 87.9 |

| VOC2007 | 92.5 | 89.6 | 91.7 |

| EuroSAT | 99.1 | 98.2 | 97.1 |

| KITTI | 78.2 | 64.7 | 77.5 |

Glint-RefSeg NO.1

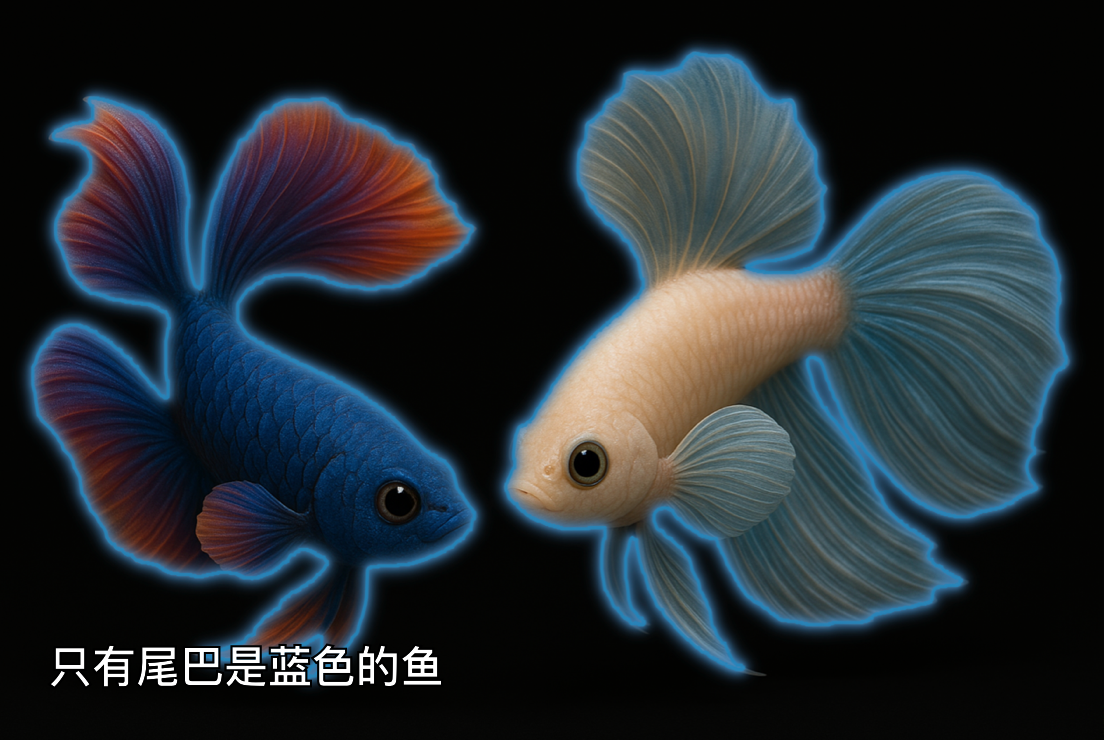

Glint-RefSeg是我们基于“灵感”训练的引用表达分割模型,它将MVT v1.1(MLCD)作为视觉编码器,同时结合大语言模型和SAM解码器,可以根据用户指令给出图像中对应物体的分割掩膜。普通的分割模型需要在构建模型前定义出需要分割物体的类别,采集对应数据进行训练。而Glint-RefSeg利用大模型的能力可以分割任何类别的物体而无需特别搜集训练。相比其他RES任务的模型,Glint-RefSeg取得了当前的SOTA (最好结果)。

用户给出一张图和一个描述,模型就可以根据描述给出对应分割掩膜。

RefCOCO Segmentation Evaluation Results

RefCOCO是一个RES数据集,测试指标Overall Intersection-over-Union (oIoU),计算的预测掩膜与真值掩膜交集面积与总并集面积的比值。

| DATASET | Split | Glint-RefSeg | EVF-SAM | GLaMM | VisionLLM v2 | LISA |

|---|---|---|---|---|---|---|

| RefCOCO | val | 83.6 | 82.4 | 79.5 | 79.2 | 74.9 |

| RefCOCO+ | testA | 82.9 | 80.0 | 78.7 | 75.8 | 70.8 |

| RefCOCOg | test | 80.5 | 78.3 | 74.9 | 74.8 | 70.6 |

MVT-VLM

立即体验在开源VLM框架LLaVA-NeXT中使用MVT-VLM作为图像编码器,Qwen作为大语言模型,可以取得比其他图像编码器更好的结果,相关代码已经合并到LLaVA-NeXT工程中。

| DATASET | MVT v1.5 | MVT v1.1 | CLIP | SigLIP | AIMv2 |

|---|---|---|---|---|---|

| ChartQA | 78.08 | 67.84 | 66.52 | 69.28 | 72.72 |

| DocVQA | 87.38 | 76.46 | 75.21 | 76.71 | 77.19 |

| InfoVQA | 53.15 | 43.48 | 38.88 | 41.38 | 35.44 |

| OCRBench | 607.00 | 531.00 | 525.00 | 554.00 | 572.00 |

MVT-feat

立即体验将Glint-MVT直接用于图像特征提取即可提升图片检索能力,在Inshop数据集上,Glint-MVT-feat的首位召回率超过最好的其他方法。

| DATASET | MVTv1 | STIR | MGA | Hyp-ViT | Hyp-DINO | CCL |

|---|---|---|---|---|---|---|

| InShop | 96.7 | 95 | 94.3 | 92.5 | 92.4 | 92.31 |

MVT-det

应用Glint-MVT做主干网络,训练检测或分割模型,检测平均精度在学术界通用测试集COCO和LVIS上相比其他主干网络有7%的提升。

| DATASET | MVT v1.5 | MVT v1.1 | DINOv2 | SigLIP |

|---|---|---|---|---|

| COCO检测 | 38.9 | 35.6 | 31.6 | 35.0 |

| COCO分割 | 31.5 | 28.6 | 24.3 | 28.1 |

| LVIS检测 | 26.5 | 22.1 | 18.7 | 21.8 |

| LVIS分割 | 21.4 | 17.8 | 14.1 | 17.3 |

MVT-cls

应用Glint-MVT做主干网络,训练分类模型,可以提升分类准确率。在全参数微调设置下,Glint-MVT-cls在ImageNet 1K分类测试集达到了87.1%的准确率。

| Method | MVT v1.1 | DINOv2 | CLIP | OPENCLIP |

|---|---|---|---|---|

| Linear Probe | 87.1 | 86 | 85.4 | 84.85 |

冯子勇

主要研究机器学习、深度学习、计算机视觉。现灵感系列模型负责人,带领团队完成灵感Glint-MVT系列模型研发。研究表征学习理论并将其应用于灵感模型中。个人日常爱吃美食和探索新事物。

王雨濛

拥有15年行业经验,专注于人工智能技术的研究与应用。在灵感大模型研发过程中主导了训练工程,开发了大部分的训练算法以及数据清洗流程。擅长设计各类算法解决实际问题,乐于分析和解决各类复杂Bug。喜欢健身、研究百科、喜欢古典音乐。

安 翔

专注于计算机视觉领域的算法开发与前沿研究,是知名开源人脸识别框架 InsightFace 的贡献者之一。在灵感研发中,主要负责视觉基座模型的训练,主攻分布式训练加速和视觉基座表征优化。业余时间,热爱游泳,享受运动带来的乐趣与放松。

赵永乐

主攻图像识别、多模态大模型与强化学习算法。在灵感研发中负责算法方向把握与模型方案设计,偏好通用图像理解与智能体任务规划,最爱喝拿铁,看足球比赛偶尔踢球放松。

谢 尹

单线程worker,负责在灵感VLM中将视觉与语言进行高效连接,促使视觉和语言部件在有限数据下实现相互融合与理解。擅长利用大规模算力集群和海量数据进行模型预训练研究。平日爱好读书与黑咖。

闫梓祯

拥有多年AI工程化经验,曾带领团队研发推理引擎、向量数据库以及数据与训练平台等核心基础设施。现聚焦于AI Infra方向,负责灵感模型的训推优化与应用落地工作。日常喜欢“调戏”大模型,沉迷提示词改写无法自拔。

于 杰

专注“折腾”AI领域“30年”,特别是深度学习工程化,对LLM、VLM等大规模模型和传统CV的小规模模型落地工程化有较为深入的研究,在灵感中负责工程化落地的相关工作,在折腾AI之余也会抽出时间来对各类游戏进行鉴赏。

杨铠成

主要研究多模态表征学习、面向Foundation Model的知识蒸馏、海量数据构建与清洗等方向。主导Glint-ME系列模型探索与训练。日常化身无情的论文阅读机,喜爱各类美食以及睡大觉。

K 罗

我们从4年前开始在银行网点实现了数十种算法试图解决室内场景下各种行为判断、物体识别,但做到一定程度就很难再提高召回率和准确率,客户开始抱怨,规模化落地遇到了很大困难,23年我们尝试了灵感预训练视觉模型,在灵感团队的帮助下,我们重构了整个训练架构,重新训练了我们的多种“瓶颈”算法,结果非常惊喜!在我们训练集不变的情况下(甚至只用了原来一半还少的数据),整个算法的效果终于得到了突破性的进展,最终让我们在24年达成了30万路镜头下数十个算法高召回、高准确的运行!感谢灵感模型,感谢灵感团队。

老胡

灵感大模型联手低代码建模引擎,直接把技战法的上线速度拉到了“即时响应”的档位。在某项目现场,客户临时抛出一个高要求:“手持鲜花、拿手机拍照的行为需要立即预警。”换作以前,这种需求少说也得几天才能上线。而这一次,我们只用了两个小时,从建模到部署,全流程搞定,现场直接上屏,零磨合上线。靠的是灵感大模型在Zero-Shot下就能精准命中的理解力,加上低代码引擎对业务场景的灵活适配。不调参、不改代码,真正把算法交付的“重工程”变成了“快反应”,把传统AI的“人工+智能”变成实战中的闪击。